Краулинговый Бюджет Сайта: Как Не Тратить Его Понапрасну?

А представьте, что таких цепочек будет много — пользователю это не заметно, но робот будет вынужден переходить от ссылки к ссылке, чтобы найти нужную страницу. Цепочка редиректов запутает робота и не позволит ему сразу попасть на нужную страницу. Повторимся, речь здесь именно о нескольких страницах с кодом 301, а не об одном редиректе. Краулинговый бюджет, как правило, изменяется прямо пропорционально времени, потраченному на одну страницу.

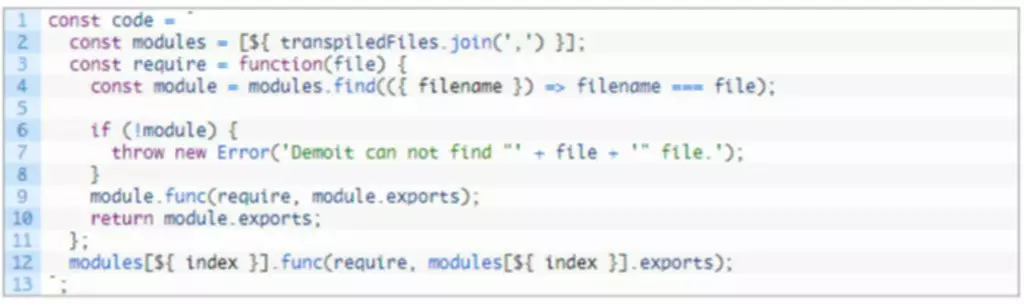

Построение масштабируемой системы управления краулинговым бюджетом требует создания надежной микросервисной архитектуры. Ядром системы выступает CI/CD pipeline на базе Jenkins, автоматизирующий развертывание конфигураций и обновление правил сканирования. Контейнеризация через Docker и оркестрация Kubernetes обеспечивают гибкое масштабирование и отказоустойчивость сервисов мониторинга.

Такие сайты, как правило, имеют большое количество страниц и сложную структуру. В первую очередь, желательно сделать страницы уникальными, ну или хотя бы большую часть из них. Все вышеперечисленные рекомендации актуальны и для интернет-магазинов, но кроме этого, при наличии большого количества вариаций фильтров, может потребоваться их проработка. Такое явление встречается в некоторых CMS системах, когда одна и та же страница доступна по разным URL-адресам. В последующем произойдет их склейка, и поисковик сам определит какая из страниц будет в выдаче, но в момент индексации на каждую из них тратятся лимиты. Но в случае крупных проектов, может заметно сказаться на скорости индексации сайта в целом.

Чем больше внешних ресурсов ссылается на конкретные страницы сайта, тем выше вероятность, что поисковый бот в первую очередь просканирует их. Представьте, что на сайт с миллионом страниц одновременно зайдёт миллион поисковых роботов. Сервер не выдержит такой нагрузки и сайт, скорее всего, «упадёт».

Как Правильно Подобрать Ключевые Слова Для Страницы Сайта

Вся история про лимит индексации завязана на Google, поэтому самый удобный способ — это посмотреть статистику обхода в Google Search Console. Чем более востребованным становится сайт, тем чаще его посещают поисковые боты. Следует избегать большого уровня вложенности страниц, стараться не превышать его более 4-х. Это значит, что пользователь с главной страницы должен добраться до любой другой не более чем за 4 клика. Страница при нормальной ее работе отдает 200 (OK) код, либо 301 при редиректе.

Например, если у вас есть страница бронирования с календарём, посетитель может нажимать на следующую кнопку столько, сколько захочет. Это тратит ваш краулинговый бюджет на сканирование роботом ненужных страниц или контента. Понимание и контроль над краулинговым бюджетом являются важными аспектами стратегии search engine optimization.

Рекомендации по сканированию можно передать вручную, либо настроить автоматическое обновление передаваемой информации. При этом следите за тем, чтобы внешние ссылки были естественными, иначе Яндекс и Google могут заподозрить вас в ссылочном спаме и понизить позиции сайта в поисковой выдаче. Прочитав эту строку, робот поймет, что по вышеуказанному адресу находится главная, то есть каноническая страница.

Поисковый робот (краулер) систематически исследует URL-адреса, проверяя их доступность и актуальность в органической выдаче. Процесс начинается с идентификации новых страниц, проверки директив в файле robots.txt и последующего определения приоритетности страниц для сканирования на основе их значимости. Эффективное управление краулинговым бюджетом становится критически важным фактором для успешной индексации сайта, особенно для крупных веб-проектов с динамическим контентом и частыми обновлениями.

Обзор Сервисов Для Создания Прототипа Сайта

Для больших сайтов это является критическим моментом, так как может существенно Регрессионное тестирование повлиять на скорость обхода и индексирование страниц. Мы используем уникальные и разнообразные анкоры с ключевыми словами и добавляем ссылки на страницы, соответствующие тематике. По нашему опыту оптимальное число внутренних ссылок на страницу — от 7 штук. Со временем страницы редиректов уходят из поля зрения поисковиков и индексируются только конечные URL. В первой части статьи рассказывали, как посчитать краулинговый бюджет, а в этой — остановимся на советах, которые помогут предотвратить или устранить технические ошибки на сайте.

Необходимо как можно скорее выявить причины и устранить их, чтобы не терять в индексации. Если речь о крауд-маркетинге, ссылки необходимо размещать только на трастовых https://deveducation.com/ сайтах, которым доверяют поисковики. И даже если пользователю кажется, что анкорная ссылка выглядит более естественно, увы, поисковые системы считают наоборот — они ценят безанкорные ссылки. Наличие у страницы обратных ссылок покажет поисковой системе, что сайту доверяют. Поисковый робот будет чаще посещать эти страницы, и бюджет сканирования увеличится.

- Ниже можно ознакомиться с информацией, которая касается распределения запросов на сканирование (по типу, по типу файла, по цели, по типу робота Googlebot).

- Его количества хватает с избытком на то, чтобы проиндексировать новые страницы.

- Современный подход к разработке сайта основан на концепции web optimization Driven Development (SDD), где SEO-специалист участвует…

На одном из наших проектов мы обнаружили, что бот тратил на проверку одной страницы 6 секунд. Это довольно много — напомним, пользователь закрывает страницу спустя примерно three секунды. Сервис подскажет конкретные действия, которые можно предпринять для увеличения скорости загрузки. Мы используем файлы cookie, чтобы вам было ещё удобнее пользоваться нашим сайтом. Продолжая использовать сайт, Вы соглашаетесь с использованием cookie-файлов. Используйте различные и уникальные текстовые анкоры, содержащие ключевые слова, и вставляйте ссылки на страницы, соответствующие тематике другой статьи.

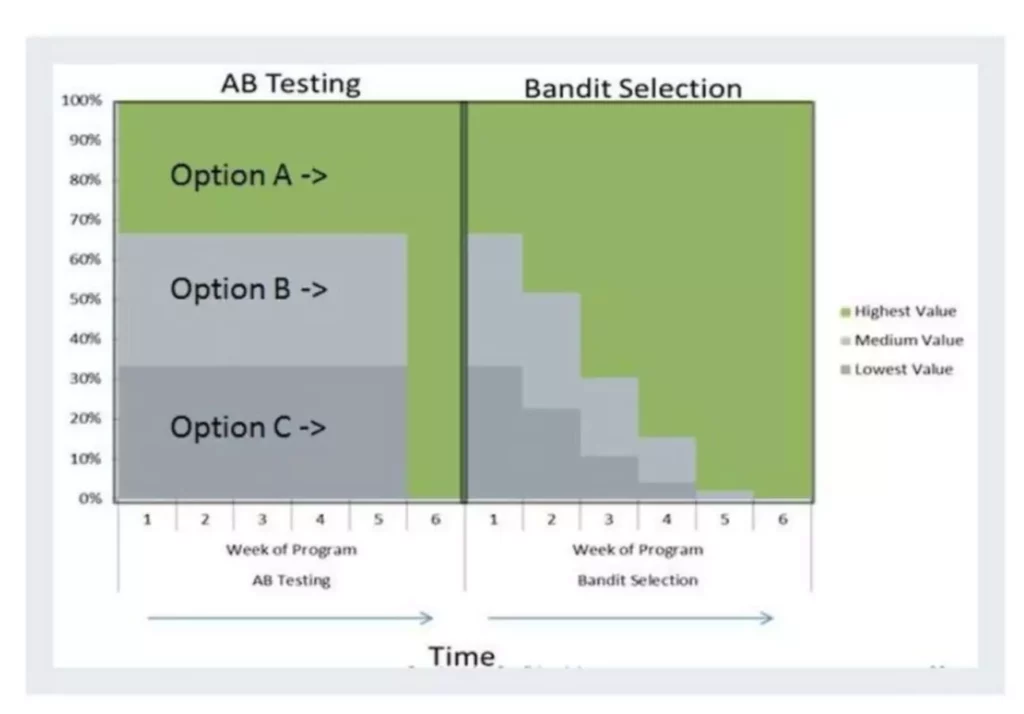

Такой комплексный подход к интерпретации данных обеспечивает обоснованность принимаемых решений и позволяет максимизировать эффективность использования краулингового бюджета. Ключевые показатели эффективности (KPI) определяются на основе ROI анализа и включают скорость индексации, качество сканирования и эффективность распределения ресурсов. Прогнозная аналитика помогает предсказывать потенциальные проблемы и планировать оптимизацию заранее. Процесс внедрения изменений включает обязательную оценку рисков и проведение A/B тестирования для валидации гипотез об улучшении эффективности сканирования. Google Analytics в сочетании с данными о сканировании помогает определить корреляцию между пользовательской активностью и поведением краулеров. Панели Яндекс.Вебмастер предоставляют дополнительные метрики, включая ошибки сканирования.

Нетрудно посчитать, что сканирование всех страниц сайта произойдет примерно через thirteen дней. Отметим, что ситуация усугубляется установленными приоритетами на индексацию страниц, частотой их обновления и уровнем вложенности самих страниц. Как результат, часть страниц будет просканирована поисковым роботом значительно позже. Карта сайта помогает поисковым роботам упросить краулинг и быстрее находить новый контент. Чтобы она работала исправно, регулярно обновляйте её и удаляйте «мусорные» страницы. Ловите наш чек-лист технической оптимизации и используйте его в работе.

Он рассчитывается для каждого веб-проекта в отдельности, исходя из доступности сервера и его спроса у пользователей. Спустя полтора месяца мы отметили, что все карточки товаров начали индексироваться в поисковиках. Это усложняет работу поисковых роботов, ведь они должны решить, какие страницы сайта нужно индексировать. Метрики глубины сканирования краулинговый бюджет (crawl depth) демонстрируют эффективность архитектуры сайта и помогают оптимизации маршрута и визита краулера. Отслеживание crawl errors и времени ответа сервера позволяет предотвратить потерю краулингового бюджета на проблемных страницах. Анализ метрик эффективности, таких как соотношение просканированных и проиндексированных страниц, помогает оценить качество индексации контента.